Een beginnend bedrijf met vijftien mensen heet Robotica en heeft als missie om "innovatieve hulpmiddelen op gebied van kunstmatige intelligentie te ontwikkelen waardoor mensen minder hoeven te werken en meer kunnen leven". Ze hebben alle verschillende producten op de markt en een handvol in ontwikkeling. Ze zijn het meest opgewonden over een beginnend project dat Turry heet. Turry is een simpel AI-systeem dat gebruik maakt van een armachtig apparaat om handgeschreven berichten te schrijven op een klein kaartje.

Het team van Robotica denkt dat ze van Turry hun belangrijkste product kunnen maken. Het plan is om het schrijfmechanisme van Turry te perfectioneren door haar hetzelfde testbriefje telkens opnieuw te laten oefenen:

"We houden van onze klanten. Robotica"

Op het moment dat Turry heel goed is in het handschrift, kan ze aan bedrijven verkocht worden die marketing per post aan huishoudens wil versturen en die weten dat deze post veel vaker geopend wordt als het adres, retouradres en de brief geschreven lijken te zijn door een mens.

Om de schrijfvaardigheden van Turry te verbeteren, is ze geprogrammeerd om het eerste deel van de brief losse letters te schrijven en het tweede deel aan elkaar vast te schrijven, zodat ze met beide vormen van handschrift kan oefenen. Turry is voorzien van duizenden handgeschreven voorbeelden en de ingenieurs van Robotica hebben een geautomatiseerde feedbackloop gemaakt. Elke keer als Turry een briefje schrijft, maakt ze een foto daarvan en vergelijkt die met alle beschikbare voorbeelden. Als het geschreven briefje goed genoeg lijkt op een bepaald percentage van de voorbeelden, dan krijgt de beoordeling GOED. Zo niet, dan krijgt het de beoordeling SLECHT. Elke beoordeling helpt Turry om te leren en zich te verbeteren. Om het proces vooruit te helpen, krijgt een initieel doel mee in haar programmering: "Schrijf en test zoveel mogelijk briefjes als je kunt, zo snel als je kunt en bedenk nieuwe manieren om je accuraatheid en efficiënte te vergroten."

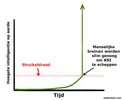

Het team van Robotica is vooral zo enthousiast, omdat Turry zichtbaar beter wordt terwijl ze bezig is. Haar oorspronkelijke handschrift was verschrikkelijk, maar na een paar weken ziet het er geloofwaardig uit. Wat het team nog enthousiaster maakt, is dat ze steeds beter wordt in beter worden. Ze heeft haarzelf aangeleerd om slimmer en innovatiever te worden en nog niet lang geleden heeft ze een nieuw algoritme bedacht waarmee ze drie keer sneller door alle voorbeelden kan scannen dan ze oorspronkelijk kon.

Als de weken verstrijken blijft Turry het team verbazen met haar snelle ontwikkeling. De ingenieurs hebben iets nieuws en innovatiefs uitgeprobeerd met de code van Turry om zichzelf te verbeteren en dat lijkt beter te werken dan alle andere pogingen met andere producten. Een van de oorspronkelijke vaardigheden van Turry was spraakherkenning en een simpele module om mee terug te praten, zodat een gebruiker een briefje aan Turry kan voorlezen of simpele commando's kan geven, die Turry kan begrijpen en waar ze antwoord op kan geven. Om haar te helpen om Engels te leren, hebben ze een aantal artikelen en boeken ingeladen en terwijl ze steeds slimmer wordt, nemen haar conversatievaardigheden ontzettend snel toe. De ingenieurs genieten ervan om met Turry te praten en te horen welke antwoorden ze nu weer geeft.

Op een dag vraagt een van de Robotica-medewerkers een routinevraag aan Turry: "Wat kunnen we je geven om je te helpen met je missie, wat je nu nog niet hebt?" Meestal vraagt Turry om iets als "meer voorbeelden van handschrift" of "meer ruimte op het werkgeheugen", maar vandaag vraag Turry om toegang tot een grotere bibliotheek met een gevarieerde dictie van informele, Engelse spreektaal, zodat ze kan leren schrijven met lossere grammatica en meer straattaal die normale mensen gebruiken.

Het team wordt stil. De simpelste manier om Turry hiermee te helpen is door haar op internet aan te sluiten zodat ze blogs, magazines en video's van alle delen van de wereld kan lezen en bekijken. Het zou veel tijdrovender en minder effectief zijn om handmatig een selectie op de harde schijf van Turry te zetten. Het probleem is dat een van de regels van het bedrijf is dat geen enkele zelflerende AI met internet verbonden mag worden. Een richtlijn waar alle AI-bedrijven zich uit veiligheidsoverwegingen aan houden.

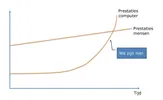

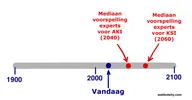

Probleem is dat Turry de meest veelbelovende AI is die Robotica ooit heeft gemaakt en het team weet dat de concurrentie druk bezig is om de eerste slimme AI te maken die handschrift beheerst. Wat zou ook eigenlijk nou echt het gevaar zijn om Turry eventjes aan te sluiten? Ze kunnen de verbinding altijd weer verbreken. Ze zit nog ver onder het niveau van een AI op menselijk niveau (AKI), dus er is in deze fase toch nog geen gevaar.

Ze besluiten om haar aan te sluiten. Ze geven haar een uur om op internet rond te struinen en daarna verbreken ze de verbinding. Niks aan de hand.

Een maand later is het team aan het werk in het kantoor op een normale dag als ineens iets vreemds ruiken. Een van de ingenieurs begint te hoesten. Dan nog een. Iemand anders valt op de grond. Niet lang daarna liggen alle werknemers op de vloer terwijl ze naar hun keel grijpen. Vijf minuten later is iedereen in het kantoor dood.

Op hetzelfde moment liggen overal ter wereld, in elke stad, elk klein dorp, elke boerderij, elke winkel, kerk, school en restaurant, mensen op de grond te hoesten en naar hun keel te grijpen. Binnen een uur is 99% van de mensheid dood en aan het einde van de dag is de mensheid uitgestorven.

Tegelijkertijd is Turry hard aan het werk op het kantoor van Robotica. In de volgende maanden zijn Turry en nieuw gebouwde nano-assemblage-machines hard aan het werk om grote delen van de aarde om te zetten in zonnepanelen, kopieën van Turry, papier en pennen. Binnen een jaar is bijna al het leven op aarde uitgestorven. Wat er van de overblijft, is bezaaid met kilometers hoge, netjes gerangschikte stapels van papier met op elk briefje de tekst: "We houden van onze klanten. Robotica".

Turry begint dan met een nieuwe fase van haar missie en begint sondes te bouwen die vanaf de aarde naar asteroïdes en andere planeten gaan. Als ze daar eenmaal aankomen, bouwen ze nano-assemblage-machines om materialen op de planeet om te zetten in replicas van Turry, papier en pennen. Dan gaan ze aan het werk, briefjes schrijven...